Actualizado por ultima vez el 7 de abril de 2022, por Luis Benites.

Los mínimos cuadrados regularizados son una forma de resolver problemas de regresión de mínimos cuadrados con una restricción adicional en la solución. La restricción se llama regularización.

La regularización limita el tamaño de los coeficientes en el método de los mínimos cuadrados de una forma sencilla: añade un término de penalización al error . Al hacer un análisis de regresión de mínimos cuadrados estándar , todo lo que estamos haciendo es tratar de minimizar los cuadrados de las distancias desde nuestro modelo hasta cada punto de datos.

Notación

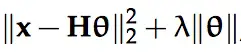

En mínimos cuadrados regularizados tratamos de minimizar aquí λ es mayor que cero, y || · || es alguna función de penalización; por ejemplo, podría ser una norma. θ es el parámetro de nuestro modelo; el parámetro que estamos tratando de encontrar, y H es lo que se llama la matriz de proyección o matriz de sombrero, una matriz conocida que usamos solo para facilitar este análisis.

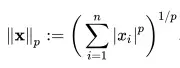

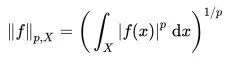

La norma, dicho sea de paso, es lo que obtenemos si traducimos nuestra función a un vector y encontramos la longitud de ese vector. La p-norma (en un espacio dimensional ap) viene dada por Generalizar el concepto de norma a un espacio dimensional infinito, la norma de cualquier función es:

Razones para usar mínimos cuadrados regularizados (RLS)

Si el análisis de mínimos cuadrados regularizados es más complicado de realizar, ¿por qué molestarse? Hay dos razones principales.

Si hay más variables que observaciones en un sistema lineal, el problema de mínimos cuadrados (realizado de la manera ordinaria) es un problema mal planteado . Es imposible encajar, porque hay infinitas soluciones. Con mínimos cuadrados regularizados, aún puede obtener una solución determinada de forma única.

A veces, incluso cuando no hay más variables que observaciones, el sistema todavía tiene problemas para generalizar. Por lo general, esto se debe a lo que llamamos sobreaprendizaje. Cada sistema de datos tendrá ruido, que no es relevante para el problema. El sobreaprendizaje ocurre cuando un modelo complejo ‘aprende el ruido’ así como el enfoque del análisis. La regularización, especialmente cuando la restricción está bien elegida para reflejar el conocimiento previo que podamos tener, evita el sobreaprendizaje y mejora la generalización del problema; es decir, hace que la solución que encontramos sea relevante para otras instancias de lo que estamos estudiando.

Referencias

Huttunen, H. (2013). Revisión de los mínimos cuadrados. Recuperado el 10 de enero de 2018 de: http://www.cs.tut.fi/~hehu/SSP/lecture8.pdf

Leykekhman, D. (2008) Regularized Linear Least Squares Problems. Recuperado el 10 de enero de 2018 de: http://www.math.uconn.edu/~leykekhman/courses/MATH3795/Lectures/Lecture_10_Linear_least_squares_reg.pdf.