Contenido de este artículo

- 0

- 0

- 0

- 0

Actualizado el 6 de diciembre de 2021, por Luis Benites.

K-nn (k-Nearest Neighbor) es una técnica de clasificación y regresión no paramétrica . La idea básica es que ingrese un conjunto de datos conocido, agregue un desconocido y el algoritmo le dirá a qué clase pertenece ese punto de datos desconocido. La incógnita se clasifica por simple votación vecinal, donde “gana” la clase de vecinos cercanos. Su uso más popular es para la toma de decisiones predictivas. Por ejemplo:

- ¿Un cliente incumplirá un préstamo o no?

- ¿El negocio va a generar ganancias?

- ¿Deberíamos expandirnos a un determinado segmento del mercado?

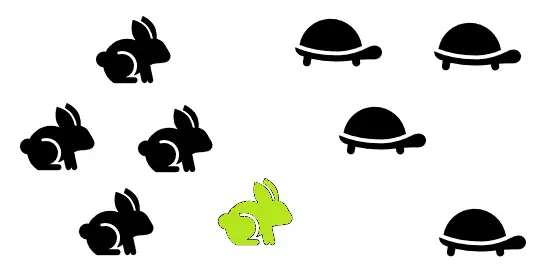

El siguiente ejemplo simple muestra cómo funciona k-nn.

Knn: Pasos

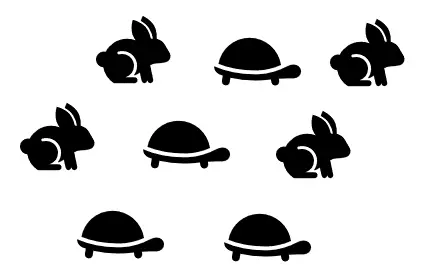

1. Toma un conjunto de datos con categorías conocidas

En este paso inicial, solo está recopilando los datos sin clasificar y sin procesar. En este ejemplo, los datos están claramente categorizados con liebres y tortugas.

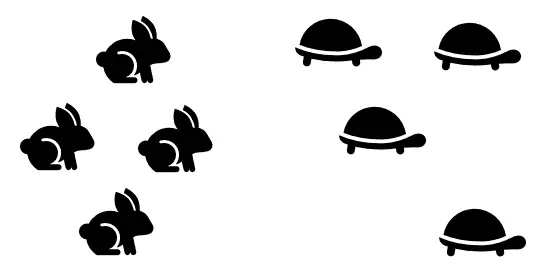

2. Agrupe los datos

Tienes algunas opciones en este paso; Cómo agrupa los datos depende de usted. (por ejemplo, con PCA u otro método de agrupación ).

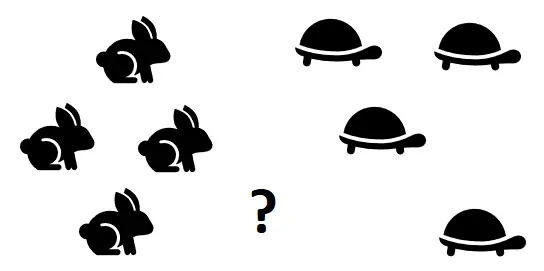

3. Agrega una celda con una categoría desconocida

4. Encuentra la «k»

Tal vez el paso más desafiante es encontrar un k que sea «perfecto». La raíz cuadrada de n (la cantidad de elementos en el conjunto de datos) es un lugar fácil para comenzar.

- √(n)

- = √(8)

- = 2,82

- = ≅ 3

Aunque la raíz cuadrada de n es simple, no es el método más preciso. Idealmente, debería usar un conjunto de entrenamiento (es decir, un conjunto bien categorizado) para encontrar una «k» que funcione para sus datos. Elimine algunos puntos de datos categorizados y conviértalos en «desconocidos», probando algunos valores de k para ver qué funciona. Un método de codo puede funcionar bien, donde encuentra un k óptimo basado en las tasas de error más bajas. Para obtener una breve descripción del método del codo, consulte: Determinación del número de grupos en una imagen .

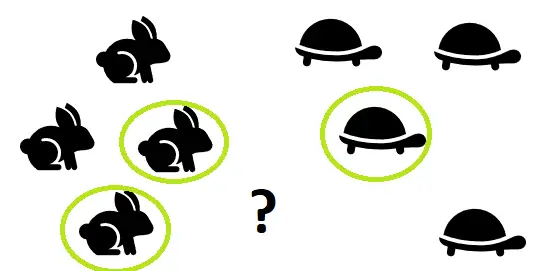

5. Localiza los “k” vecinos más cercanos

Para este ejemplo, solo usé el visual para ubicar a los vecinos más cercanos.

6. Clasifica el nuevo punto

El nuevo punto se clasifica por mayoría de votos. Si la mayoría de tus vecinos son tortugas, lo más probable es que tú también seas una tortuga. En este caso, dos de cada tres vecinos del desconocido son liebres, por lo que el nuevo punto se clasifica como liebre.

Ver también: agrupamiento K-nn explicado en una imagen .

¿Te hemos ayudado?

Ayudanos ahora tú, dejanos un comentario de agradecimiento, nos ayuda a motivarnos y si te es viable puedes hacer una donación:La ayuda no cuesta nada

Por otro lado te rogamos que compartas nuestro sitio con tus amigos, compañeros de clase y colegas, la educación de calidad y gratuita debe ser difundida, recuerdalo: