Contenido de este artículo

Actualizado el 21 de julio de 2024, por Luis Benites.

¿Qué es un modelo parsimonioso?

Los modelos parsimoniosos son modelos simples con gran poder predictivo explicativo. Explican los datos con un número mínimo de parámetros o variables predictoras .

La idea detrás de los modelos parsimoniosos proviene de la navaja de Occam , o “la ley de la brevedad” (a veces llamada lex parsimoniae en latín). La ley establece que no debe usar más “cosas” de las necesarias; En el caso de los modelos parsimoniosos, esas “cosas” son parámetros. Los modelos parsimoniosos tienen una parsimonia óptima, o la cantidad justa de predictores necesarios para explicar bien el modelo.

Comparación de modelos

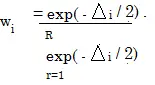

Los pesos de Akaike se utilizan en AIC.

Por lo general, existe una compensación entre la bondad del ajuste y la parsimonia: los modelos de baja parsimonia (es decir, modelos con muchos parámetros) tienden a tener un mejor ajuste que los modelos de alta parsimonia. Esto no suele ser algo bueno; agregar más parámetros generalmente da como resultado un buen ajuste del modelo para los datos disponibles, pero es probable que ese mismo modelo sea inútil para predecir otros conjuntos de datos.

Encontrar el equilibrio adecuado entre parsimonia y bondad de ajuste puede ser un desafío. Los métodos populares incluyen el criterio de información de Akaike (AIC), el criterio de información bayesiano (BIC), los factores de Bayes y la longitud mínima de descripción .

- El criterio de información de Akaike compara la calidad de un conjunto de modelos; El AIC clasificará cada opción de mejor a peor. El modelo más parsimonioso será el que no se ajuste por debajo ni por encima. Una desventaja es que la AIC no dice nada sobre la calidad; Si ingresa una serie de modelos de baja calidad, el AIC elegirá el mejor de ese conjunto de baja calidad.

- El Criterio de Información Bayesiano (BIC) es casi lo mismo que el AIC, aunque tiende a favorecer modelos con menos parámetros. El BIC también se conoce como criterio de información de Schwarz o BIC de Schwarz.

- Los factores de Bayes comparan modelos utilizando distribuciones previas . Es similar a la prueba de razón de verosimilitud , pero no es necesario anidar los modelos . La selección del modelo basada en los factores de Bayes puede ser aproximadamente igual a la selección del modelo BIC. Sin embargo, BIC no requiere conocimiento previo, por lo que a menudo se prefiere.

- Longitud mínima de descripción (MDL): comúnmente utilizada en informática y ciencias de la información, funciona sobre la base de que las cadenas de datos relacionados se pueden comprimir, lo que reduce la cantidad de variables predictoras.

¿Te hemos ayudado?

Ayudanos ahora tú, dejanos un comentario de agradecimiento, nos ayuda a motivarnos y si te es viable puedes hacer una donación:La ayuda no cuesta nada

Por otro lado te rogamos que compartas nuestro sitio con tus amigos, compañeros de clase y colegas, la educación de calidad y gratuita debe ser difundida, recuerdalo: