Contenido de este artículo

Actualizado el 26 de marzo de 2022, por Luis Benites.

¿Qué es la Regularización?

La regularización es una forma de evitar el sobreajuste al penalizar los coeficientes de regresión de alto valor. En términos simples, reduce los parámetros y reduce (simplifica) el modelo. Es probable que este modelo más simplificado y parsimonioso funcione mejor en las predicciones. La regularización agrega penalizaciones a los modelos más complejos y luego ordena los modelos potenciales de menor a mayor sobreajuste; El modelo con la puntuación más baja de «sobreajuste» suele ser la mejor opción para el poder predictivo.

¿Por qué es necesaria la regularización?

La regularización es necesaria porque los métodos de regresión de mínimos cuadrados , en los que se minimiza la suma residual de los cuadrados , pueden ser inestables. Esto es especialmente cierto si hay multicolinealidad en el modelo. Sin embargo, la mera práctica del ajuste de modelos conlleva un gran escollo: cualquier conjunto de datos puede ajustarse a un modelo, incluso si ese modelo es ridículamente complejo.

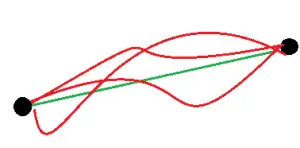

Por ejemplo, tome un conjunto de datos simple de dos puntos. El modelo más simple es una línea recta a través de los dos puntos, o un polinomio de primer grado . Sin embargo, un número infinito de otros modelos también podrían ajustarse a polinomios de segundo y tercer grado, y así sucesivamente.

Varios modelos pueden ajustar un conjunto de dos puntos, incluido un modelo lineal (verde) y un número ilimitado de modelos polinómicos de mayor grado (rojo).

Ajustar una pequeña cantidad de datos a menudo conducirá a un modelo complejo y sobreajustado. Un modelo más simple puede no ser adecuado y tendrá un desempeño deficiente con las predicciones. El hecho de que dos puntos de datos encajen perfectamente en una línea no significa que un tercer punto caiga exactamente en esa línea; de hecho, es muy poco probable. En pocas palabras, la regularización penaliza los modelos que son más complejos a favor de modelos más simples (aquellos con coeficientes de regresión más pequeños ), pero no a expensas de reducir el poder predictivo.

Términos de penalización

La regularización funciona sesgando los datos hacia valores particulares (como valores pequeños cercanos a cero). El sesgo se logra agregando un parámetro de ajuste para fomentar esos valores:

- La regularización L1 añade una penalización L1 igual al valor absoluto de la magnitud de los coeficientes. En otras palabras, limita el tamaño de los coeficientes. L1 puede generar modelos dispersos (es decir, modelos con pocos coeficientes); Algunos coeficientes pueden convertirse en cero y eliminarse. La regresión de Lasso utiliza este método.

- La regularización L2 añade una penalización L2 igual al cuadrado de la magnitud de los coeficientes. L2 no producirá modelos dispersos y todos los coeficientes se reducen por el mismo factor (no se elimina ninguno). La regresión de cresta y las SVM utilizan este método.

- Las redes elásticas combinan los métodos L1 y L2, pero agregan un hiperparámetro (consulte este artículo de Zou y Hastie) .

Referencias

Bühlmann, Peter; Van De Geer, Sara (2011). “ Estadística para datos de alta dimensión ”. Serie Springer en estadísticas

¿Te hemos ayudado?

Ayudanos ahora tú, dejanos un comentario de agradecimiento, nos ayuda a motivarnos y si te es viable puedes hacer una donación:La ayuda no cuesta nada

Por otro lado te rogamos que compartas nuestro sitio con tus amigos, compañeros de clase y colegas, la educación de calidad y gratuita debe ser difundida, recuerdalo: